Open Source:中文唤醒词数据库﹣HI-MIA

人们对自己声音的好奇、认知和应用在当今智能家居的催化下,显现出空前高涨的渴望和需求。而现实状况是,在语音算法方面在进讲和远讲还有很多问题需要解决,特别是远讲的场景。众所周知,大多数公开可用的数据库是文本无关的单通道近讲数据。

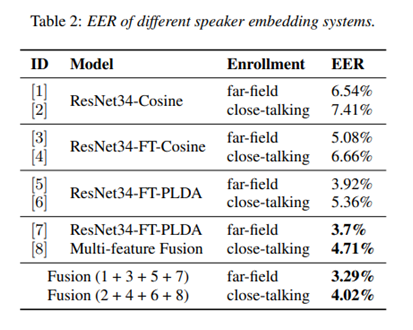

近日昆山杜克大学与AISHELL共同推出了一个基于远场文本相关的说话人认证数据库﹣HI-MIA发布在语音数据开源平台openslr上(http://www.openslr.org/85/)。并发表在论文“HI-MIA : A FAR-FIELD TEXT-DEPENDENT SPEAKER VERIFICATION DATABASE AND THE BASELINES”中,介绍了HI-MIA数据库,还提出了一套端到端的神经网络基线系统,而研究表明这套系统在远讲注册远讲测试任务中EER可以达到3.29%,在近讲注册远讲测试任务中EER可以达到4.02%。

HI-MIA数据库

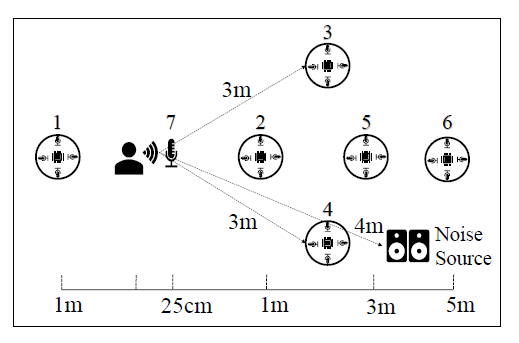

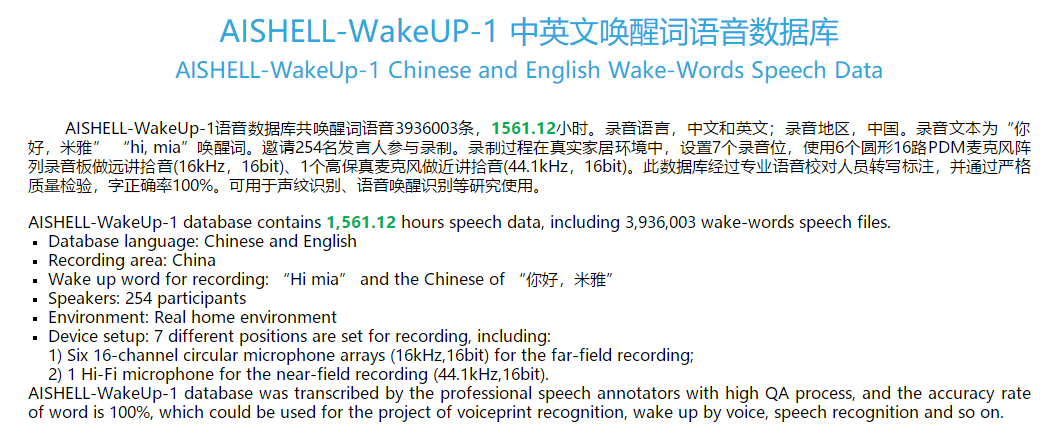

HI-MIA,是一个智能家居场景下的固有唤醒词数据库。该数据库共包含340个说话人,每个说话人语料包含了近场麦克风拾音和远场麦克风阵列的多通道拾音。它可用于声纹识别、语音唤醒识别等研究。HI-MIA包含两个子数据库分别覆盖近讲高保真麦克风、1/3/5米圆型阵列的数据,254人的AISHELL-WakeUp-1(http://www.aishelltech.com/wakeup_data) 和86人的AISHELL-2019B-EVAL数据集(http://www.aishelltech.com/AISHELL_2019)。

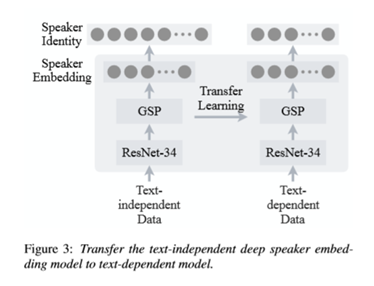

远场说话人基线系统采用的是深度说话人嵌入系统,这一系统初始是用于文本无关的说话人认证并且该系统优势已经在说话人识别和远场场景中得到了证明。

值得注意的是,在文本相关的远场说话人数据量并不多的情况,使用大量文本无关的说话人数据来训练基线说话人模型是很重要的。另外,通过扩充注册数据可以减少测试集和注册集不匹配这一问题。

测试

在实验中,选择了AISHELL-2数据集,使用这个数据集模拟远场数据作为文本无关的数据库,对ASV模型进行预训练。使用AISHELL-WakeUp作为微调训练数据,在AISHELL-2019B-EVAL中挑选了最具挑战性的最后42人数据作为测试集。实验设定了两个任务,分别为近场注册远场测试和远场注册远场测试。实验结果如下图所示。

在有限的文本相关数据下的训练方法和策略,以及相应的注册数据扩充策略。结果表明,将注册信息扩展到测试信息可以有效地提高系统性能。

相信未来会有更多的远场语音数据去支持语音交互的研究工作,提高识别准确率和人机的交互体验。